Geschichte der Physik

Die Geschichte der Physik als einer eigenständigen Naturwissenschaft begann Anfang des 17. Jahrhunderts mit der Einführung der experimentellen Methode der wissenschaftlichen Erkenntnisfindung, im Wesentlichen durch Galileo Galilei. Er und andere Begründer der Physik bezogen sich noch vielfach auf überlieferte Schriften der Antike. Diesen stellten sie aber eigene Beobachtungen entgegen, die sie in sorgfältig geplanten und mit mathematischen Methoden ausgewerteten Experimenten gewonnen hatten. Zudem forderten sie für die so gewonnenen Ergebnisse den Vorrang vor rein philosophisch oder theologisch begründeten Aussagen über die Natur.

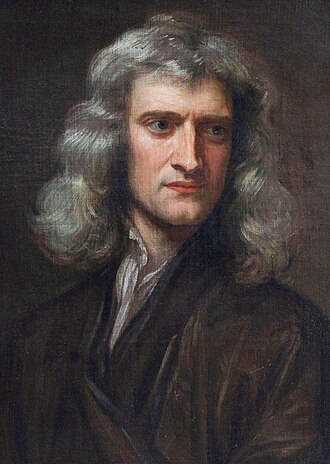

Bis Ende des 19. Jahrhunderts entwickelte sich die klassische Physik: Zuerst, aufbauend auf dem Werk von Isaac Newton, die Klassische Mechanik, die sich mit der Bewegung und Wechselwirkung von Körpern beschäftigt. Zuletzt die Elektrodynamik, nachdem James Clerk Maxwell eine Theorie gefunden hatte, die alle elektrischen und magnetischen Effekte in einheitlicher Weise beschreibt. Nach und nach gelang es, fast alle damals bekannten Phänomene auf diese beiden Grundlagen zurückzuführen. Insbesondere wurde Hitze in der Thermodynamik als ungeordnete Bewegung von Teilchen, und Licht in der Optik als elektromagnetische Welle verstanden. Experimentelle Befunde, darauf aufbauende Theorien sowie Erkenntnisse aus der Chemie ließen den Aufbau der Materie aus Atomen erkennen.

Anfang des 20. Jahrhunderts kam es, ausgelöst durch die spezielle und die allgemeine Relativitätstheorie von Albert Einstein einerseits, sowie die Quantenphysik andererseits, zu einem Paradigmenwechsel. Die damals beginnende moderne Physik baut auf Begriffen von Raum, Zeit und Materie auf, die grundlegend anders sind als die der klassischen Physik, wobei deren bewährte Ergebnisse jedoch vollständig erhalten bleiben. Damit erweiterte und vertiefte sich das Wissen sowohl im mikroskopisch Kleinen (Teilchen-, Kern- und Atomphysik) als auch im astronomisch Großen (Astrophysik und Kosmologie). Vor allem mit der Festkörperphysik und der Laserphysik lieferte und liefert die moderne Physik außerordentlich wichtige Grundlagen für technische Anwendungen in den verschiedensten Lebensbereichen.

Die Quantenphysik und die beiden Relativitätstheorien bilden heute die Grundpfeiler des physikalischen Weltbilds.

Vorgeschichte der Physik

Antike

Die griechische Naturphilosophie griff mesopotamische und ägyptische Kenntnisse auf und suchte nach grundlegenden Erklärungsprinzipien. Einzelne Sachverhaltsbeschreibungen wurden bereits mathematisiert. Eine experimentelle Methodik war jedoch noch nicht etabliert.

Die ionische materialistische Naturphilosophie eines Thales, Anaximander, Anaximenes, Heraklit erwarb Kenntnisse über Naturphänomene wie Ab- und Zunahme der Luftdichte, den Aufstieg warmer Luft, magnetische Anziehung und Bernsteinreibung.[1]

Empedokles begründete die lange Zeit maßgebliche Lehre von vier Elementen. Leukippos und Demokrit führten die von Epikur weiterverfolgte Atomhypothese ein: alles besteht aus kleinsten Teilchen, die selbst nicht teilbar oder intrinsisch wandelbar sind und deren Zusammensetzung den Wandel der Phänomene erklärt.

Im heutigen Gebiet der Optik entwickelten die griechischen Philosophen Pythagoras, Demokrit, Empedokles und andere mehrere Theorien des Lichts.[2] Euklid entwickelte sie nach dem von ihm entworfenen Ideal der Geometrie weiter und untersuchte insbesondere die Spiegelung mathematisch. Ptolemaios folgte ebenfalls diesem mathematischen Methodenideal und maß u. a. die Lichtbrechung durch Experimente. Heron von Alexandria versuchte, das Reflexionsgesetz und die Lichtbrechung dadurch zu erklären, dass das Licht den kürzesten Weg zwischen zwei Punkten nimmt.

Bei den in der Legende von Pythagoras in der Schmiede beschriebenen Zahlenverhältnissen von Wohlklängen handelt es sich um das erste konkret und quantitativ beschriebene Naturgesetz, ohne dass jedoch klar ist, wie man zu diesem Gesetz gelangt ist.[3]

Platon nahm immaterielle Urbilder an und versuchte, damit Bewegung und Gravitation zu erklären. Im Timaios entwickelte er Ansätze einer Kosmologie. Nach der Ontologie des Aristoteles ist die Identität und der Wandel der Objekte durch das Arrangement zweier Grundprinzipien erklärbar, Form und Materie. Er nahm vier Ursachen an, unter welchen die Bewegungsursache nur eine ist (neben Ziel, Form und Materie). Seine Bewegungslehre ist eine Vorform der klassischen Dynamik. Auch sonst beschrieb er Naturphänomene eher materialistisch. Aristoteles hat diverse physikalische und sonstige naturwissenschaftliche Studien betrieben und Werke oder Vortragsnotizen u. a. über die Physik, den Himmel, das Wetter, Entstehen und Vergehen, Fragen der Mechanik zusammengestellt.

Mit seinem Werk Physik prägte Aristoteles den Begriff "Physik" (alles natürlich Gewachsene im Gegensatz zu Artefakten); sein Werk beschreibt die Natur nicht im heutigen Sinne mathematisch.

Darüber hinaus bestand ein ausgeprägtes Anwendungsinteresse, das Erfinder wie Ktesibios, Philon von Byzanz oder Heron prägte, die hydraulische, pneumatische und mechanische Phänomene nutzten.[1] Archimedes beschrieb um 250 v. Chr. den statischen Auftrieb und die Hebelgesetze. Er bestimmte den Schwerpunkt von Flächen und Körpern und mathematisierte nach dem Vorbild des Euklid Statik und Hydrostatik.

Mittelalter und Renaissance

Zahlreiche antike und frühmittelalterliche Kompendien überliefern die physikalischen Kenntnisse der antiken Wissenschaftler.

Im arabischen Kulturraum sind u. a. die Zusammenstellungen und Kommentierungen von Avicenna und Averroes wichtig, die auch für die im 12. und 13. Jahrhundert erfolgende Rezeption antiken Wissens im lateinischen Westen bedeutsam werden.

Insgesamt hat sich das bei Aristoteles stark ausgeprägte Interesse an einer Ausweitung physikalischer Einzelerkenntnisse und ihrer zusammenfassenden Systematisierung im lateinischen Westen über längere Zeit hin verloren. Stattdessen überwiegt ein Interesse an der Natur als Zeichen für den göttlichen Willen und daher einer Quelle der Offenbarung, wie etwa schon in der Bibelauslegung des Augustinus um das Jahr 400.[4]

Ein Interesse an der Natur im Sinne empirischer Erklärungssuche wird Anfang des 12. Jahrhunderts rudimentär greifbar, etwa bei Adelard von Bath, der die Natur nicht mehr als „Buch“ göttlicher Zeichen versteht, sondern in seinen Quaestiones naturales biologische, physiologische, kosmologische und klimatologische Phänomene beschreibt und sich nicht auf Buchwissen, sondern Beobachtung, experimentum, stützt, ohne dies freilich methodologisch auszuarbeiten.[5]

Robert Grosseteste entwickelt im Anschluss an die platonische geometrische Weltbetrachtung eine Lichttheorie, welche die quantitative, qualitative, räumliche und substantielle Bewegung auf Lichtgesetze zu reduzieren versucht (De motu corporali et luce und De lineis). Damit wird die Optik (bei Robert scientia perspectiva) eine „Modellwissenschaft“[6] Auch Roger Bacon will alle Naturkausalität als Wirkung energetischer Strahlung erklären.[7] Witelo gibt der Optik einen ähnlich zentralen Rang in seiner Übertragung und Erklärung der Perspectiva von Ibn al-Haitam.[8] Die ähnlich angelegte Perspectiva communis Johannes Peckhams wird noch von Lorenzo Ghiberti und Leonardo da Vinci verwendet.[9]

Kurz vor Mitte des 14. Jahrhunderts arbeitet Nikolaus von Autrecourt eine scharfe Kritik am Wissenschaftsstatus metaphysischer Ansprüche auf Erkenntnis und Disziplinprimat aus. Parallel erfordert und ermöglicht die merkantile und technische Entwicklung des 14. Jahrhunderts eine Quantifizierung der Natur und eine Kritik der aristotelischen Bewegungslehre, d. h. allgemein der Verursachungslehre. Dem widmen sich etwa Franz von Marchia und Johannes Buridan, der Begründer der sog. Impetustheorie,[10] den Pierre Duhem einen „Vorläufer Galileis“ nennt.[11] Diese Theorie bleibt langezeit maßgeblich, bis sie durch die Trägheitstheorie abgelöst wird. Nikolaus von Oresme, Albert von Rickmersdorf und Marsilius von Inghen entwickeln sie weiter, nur in Oxford begegnet man ihnen mit Zurückhaltung (Thomas Bradwardine) oder Ablehnung (Richard Swineshead).[12] Die beiden letztgenannten gehören mit Johannes Dumbleton und William Heytesbury zu den sog. „Oxford Calculators“ am Merton College, die eine allgemeine Mathematisierung der Naturbeschreibung versuchen.

Nikolaus von Oresme nimmt auch sonst viele Anregungen Buridans auf und entwickelt sie z. B. unter Berufung auf das Prinzip der Denkökonomie zu der These weiter, dass die Annahme der Erdrotation ebenso durchführbar sei, wie die überkommene Vorstellung einer Rotation der Sonne um die Erde. Ebenso wird die aristotelische Zweiteilung der Physik in eine Welt über und unter dem Mond von ihm in Frage gestellt, die Relativität aller Bewegungszuschreibungen erkannt und ein Koordinatensystem eingeführt, das quantitativ genaue Beschreibungen qualitativer Veränderungen erlaubt.[13] Im Gefolge dieser Ansätze steht zu Anfang des 15. Jahrhunderts z. B. Biagio Pelacani da Parma,[14] zur Mitte des 15. Jahrhunderts beispielsweise Nikolaus von Kues, dessen Versuche mit der Waage quantitative Verfahren für die Medizin beschreiben und als exemplarisch für die Interessen der Frührenaissance gelten können.

Der wohl bekannteste Naturforscher der Renaissance, Leonardo da Vinci (geb. 1452), hat sich vor allem aus praktischen Motiven als Maler und Ingenieur für Optik, Wasserbewegungen, Kraftübertragung und Vogelflug interessiert und dabei genaue Beobachtungen der Natur durchführt.

Klassische Physik

16. und 17. Jahrhundert

Die Überwindung der vorherrschenden Vorstellungen begann in der Astronomie der Neuzeit mit Nikolaus Kopernikus (De revolutionibus orbium coelestium, 1543) und dem heliozentrischen Weltbild. Unterstützung fand dieses Modell, nachdem Johannes Kepler das Beobachtungsmaterial von Tycho Brahe ausgewertet hatte und insbesondere Galileo Galilei mit dem Fernrohr die beobachtende Astronomie revolutionierte.

Um 1600 begründete William Gilbert mit seinen Experimenten die Lehre des Magnetismus und der Elektrostatik und konnte als erster zeigen, dass es sich dabei um verschiedene Phänomene handelte. Außerdem war er der erste, der die Gestalt des Erdmagnetfeldes richtig erkannte.

In der Mechanik war René Descartes einer der Ersten, die sich von aristotelischen Vorstellungen abwandten und versuchten, Bewegungen von Körpern allein mit der Kraft des Verstandes zu ergründen und rational zu beschreiben. Im Gegensatz zu ihm vertrat Galilei jedoch eine Schule, die ihre Schlussfolgerungen nicht nur auf logisches Schließen, sondern vor allem auch auf reproduzierbare Beobachtungen und Experimente aufbaut. Erst dadurch entwickelte sich die Physik von der Naturphilosophie zu einer modernen Naturwissenschaft. Galilei erkannte, dass sich alle Körper auf der Erde nach denselben Gesetzen bewegen, die mathematisch formuliert und experimentell überprüft werden können. Zu seinen Entdeckungen gehört das Gesetz des freien Falls, das im Widerspruch zur Lehre des Aristoteles stand, ebenso wie eine Formulierung des Trägheitsgesetzes, die Wurfparabel und das Pendelgesetz. Galilei wirkte mit seiner Vorstellung der Physik als experimenteller Wissenschaft schulbildend, so in der Erforschung des Luftdrucks und der Natur des Vakuums (von Evangelista Torricelli über Blaise Pascal zu Otto von Guericke). Robert Boyle erforschte im 17. Jahrhundert die Gasgesetze und Christiaan Huygens baute die schon von Galilei vorgeschlagene Pendeluhren, fand die Zentrifugalkraft und verwendete bei Betrachtung des elastischen Stoßes ein Relativitätsprinzip (siehe Galilei-Transformation).

Die Grundlagen der klassischen Mechanik wurden 1687 im Wesentlichen von Isaac Newton in seinem Hauptwerk Philosophiae Naturalis Principia Mathematica begründet und formuliert (Newtonsche Gesetze). Hauptziel war zunächst die Erklärung der Keplerschen Gesetze der Himmelsmechanik aus einem universellen Gravitationsgesetz, das sowohl auf der Erde als auch für die Himmelskörper gilt. Eine experimentelle Bestätigung im Labor sowie eine Bestimmung der Gravitationskonstante gelang jedoch erst Henry Cavendish über 100 Jahre später. Newton wandte seine Gesetze der Mechanik aber auch schon zum Beispiel auf die Bewegung von anderen Körpern und von Flüssigkeiten an.

Newton nimmt insgesamt eine überragende Stellung in der Geschichte der Physik und in der Mathematisierung der Naturwissenschaften ein. Er leistete auch wichtige Beiträge zur Optik (Spiegelteleskop, Prisma). Im Gegensatz zu Christiaan Huygens (Wellenoptik) vertrat er eine Korpuskulartheorie des Lichts.

18. Jahrhundert

Die in der Formulierung der Mechanik benutzte, von Newton und unabhängig von Gottfried Wilhelm Leibniz erfundene Infinitesimalrechnung wurde ebenso wie die Mechanik insbesondere auf dem europäischen Kontinent ausgebaut, nachdem sich die britischen Mathematiker unter anderem in Folge des Prioritätsstreits zwischen Newton und Leibniz isoliert hatten. Differentialgleichungen bildeten danach die Grundlage für die Formulierung vieler Naturgesetze.

Mathematiker und Physiker wie Daniel Bernoulli, Jean-Baptiste le Rond d’Alembert, Leonhard Euler, Joseph-Louis Lagrange (Mécanique analytique 1788, Lagrange-Formalismus) und Pierre-Simon Laplace (dessen Werk als Höhepunkt der Entwicklung der Himmelsmechanik galt) entwickelten die Mechanik auf dem Kontinent wesentlich weiter unter anderem mit Verwendung von Variationsprinzipien (Prinzip der kleinsten Wirkung). Insbesondere Frankreich dominierte Ende des 18. Jahrhunderts auf dem Gebiet der theoretischen Physik, wobei die treibenden Kräfte vielfach noch in der theoretischen Astronomie (Himmelsmechanik) lagen und die Grenzen zwischen theoretischen Physikern und Mathematikern noch nicht so wie im späteren 20. Jahrhundert bestanden.

Das 18. Jahrhundert sah auch eine vielfältige Beschäftigung mit dem Phänomenen der Elektrizität. Spannungsgeneratoren (Elektrisiermaschinen) und Kondensatoren in Form Leidener Flaschen fanden weite Verbreitung in den physikalischen Kabinetten des Barocks. Reproduzierbare quantitative Ergebnisse ergaben sich nach Einführung der Batterie durch Alessandro Volta (um 1800). Gegen Ende des Jahrhunderts formulierte Charles-Augustin de Coulomb die Gesetze der Elektrostatik.

Im 18. und Anfang des 19. Jahrhunderts befassten sich auch bedeutende Philosophen und Intellektuelle mit der Physik. Bekannt ist der Beitrag von Immanuel Kant zur Kosmogonie und die Farbenlehre (1810) von Johann Wolfgang von Goethe, die dieser für bedeutender als sein literarisches Werk hielt. Die Naturphilosophie des deutschen Idealismus insbesondere über Friedrich Wilhelm Joseph Schelling und Georg Wilhelm Friedrich Hegel war im deutschsprachigen Raum zeitweise sehr einflussreich und Schellings Naturphilosophie beeinflusste Chemiker, Biologen und in der Physik zum Beispiel Hans Christian Ørsted und Johann Wilhelm Ritter.[15] Sie hatte eine spekulative Physik zur Folge (so der Titel einer Zeitschrift des Schelling-Kreises in Jena), die Anfang des 19. Jahrhunderts in Deutschland von Physikern wie Johann Christian Poggendorff, dem Herausgeber der Annalen der Physik, heftig bekämpft wurde. Das hatte auch noch in den 1840er Jahren zur Folge, dass die frühen aus heutiger Sicht wegweisenden Arbeiten zur Energieerhaltung von Robert Mayer und Hermann von Helmholtz dort nicht erscheinen konnten[16] da die betreffenden Arbeiten Poggendorff zu spekulativ erschienen, sie von Medizinern stammten und außerdem besonders was Mayer betraf unklar und von naturphilosophischem Denken beeinflusst waren[17]. Hier wird auch das Bestreben nach Professionalisierung und Abgrenzung der Physik als Disziplin in der ersten Hälfte des 19. Jahrhunderts deutlich. Natural Philosophy war noch lange in England die Bezeichnung für Theoretische Physik, wie sich auch an der Benennung der zugehörigen Lehrstühle zeigt.

19. Jahrhundert

Das 19. Jahrhundert ist insbesondere durch die Entwicklung der Gesetze der Thermodynamik und die Entwicklung des Feldkonzepts auf dem Gebiet der Elektrodynamik, gipfelnd in den Maxwellschen Gleichungen, gekennzeichnet.

Die Grundlagen der Thermodynamik wurden durch Sadi Carnot 1824 gelegt, der Kreisprozesse mit idealisierten Wärmekraftmaschinen betrachtete. Dabei wurde auch das Energiekonzept und das Konzept der Energieerhaltung herausgearbeitet, unter anderem in Arbeiten von Julius Robert von Mayer, den Experimenten von James Prescott Joule (experimentelle Messung des Wärmeäquivalents von Arbeit), durch Rudolf Clausius, von dem auch Entropie-Begriff und 2. Hauptsatz der Thermodynamik stammen, Lord Kelvin und Hermann von Helmholtz. Eine mikroskopische Interpretation der Thermodynamik als statistische Theorie von Ensembles, die Gesetzen der klassischen Mechanik gehorchen, erfuhr die Thermodynamik in der statistischen Mechanik, die insbesondere von James Clerk Maxwell, Josiah Willard Gibbs und Ludwig Boltzmann begründet wurde. Max Planck und Albert Einstein, die Anfang des 20. Jahrhunderts die moderne Physik wesentlich begründeten, waren noch als Spezialisten in der Thermodynamik und statistischen Mechanik ausgebildet und machten sich zunächst auf diesen Gebieten einen Namen.

Aus Betrachtungen zur Wärmeleitung gewann Joseph Fourier die für die theoretische Physik grundlegende Methode der Fourieranalyse. Fortschritte in der Kontinuumsmechanik wurden in der Formulierung der Navier-Stokes-Gleichungen als Erweiterung der Eulergleichungen idealer Flüssigkeiten erbracht sowie in den Untersuchungen zur Turbulenz durch Osborne Reynolds. Das 19. Jahrhundert brachte auch wesentliche Fortschritte auf dem Gebiet der Technischen Mechanik, der Elastizitätstheorie und der Akustik (Wellenphänomene wie der Doppler-Effekt nach Christian Doppler).

Die Grundlagen der Elektrodynamik legten Hans Christian Ørsted (Zusammenhang von Elektrizität (Strom) und Magnetismus), André-Marie Ampère und Michael Faraday (Elektromagnetische Induktion, Feldkonzepte). Zusammengefasst und in einer einheitlichen Nahwirkungstheorie wurde die Elektrodynamik von James Clerk Maxwell beschrieben. Er lieferte damit auch eine elektromagnetische Theorie des Lichts (die Wellennatur des Lichts hatte sich schon Anfang des Jahrhunderts mit Thomas Young und Augustin Jean Fresnel durchgesetzt). Wesentliche Anteile an der Ausarbeitung hatten danach Oliver Heaviside und Heinrich Hertz, der als Erster elektromagnetische Wellen nachwies. Maxwell ging – wie auch die meisten anderen Physiker seiner Zeit – davon aus, dass sich die elektromagnetischen Wellen in einem Medium ausbreiten, das den gesamten Raum ausfüllt, dem Äther. Alle Versuche, diesen Äther experimentell nachzuweisen, insbesondere das Michelson-Morley-Experiment, schlugen jedoch fehl, weshalb die Äther-Hypothese später fallen gelassen werden musste.

Maxwell war einer der herausragenden Vertreter der theoretischen Physik, die im 19. Jahrhundert aus Großbritannien kamen und das Land im 19. Jahrhundert führend in der Physik machten. Zu ihnen gehörte auch William Rowan Hamilton, der eine später in der Quantenmechanik einflussreiche neue Formulierung von Mechanik und geometrischer Optik fand (Hamiltonsche Mechanik), Lord Kelvin und Lord Rayleigh (Theory of Sound). In Deutschland war Hermann von Helmholtz in Berlin die dominierende Persönlichkeit in der Physik mit Beiträgen auf den unterschiedlichsten Gebieten.

Insgesamt breitete sich gegen Ende des 19. Jahrhunderts die Vorstellung aus, die Physik wäre mehr oder weniger abgeschlossen, es gebe nichts Neues mehr zu entdecken. Im Nachhinein zeigten sich aber schon damals einige deutliche Hinweise, dass dem nicht so war: In der Chemie ließen gewisse Gesetzmäßigkeiten den atomaren Aufbau der Materie erahnen (wobei es Ende des 19. Jahrhunderts auch einflussreiche Gegner des Atomismus gab). In der Spektralanalyse (Joseph von Fraunhofer, Gustav Robert Kirchhoff, Robert Bunsen) wurden gewisse Regelmäßigkeiten der Spektren entdeckt (siehe Rydberg-Formel), die man sich nicht erklären konnte. Die Beeinflussbarkeit der Spektren durch Magnetfelder im Zeemaneffekt war ein erster Hinweis auf Elektronen in Atomen. Die Entdeckungen des Elektrons in Kathodenstrahlen (J. J. Thomson), der Röntgenstrahlung (Röntgen), des Photoeffekts (Hallwachs), der Radioaktivität (Becquerel) usw. warfen weitere damals ungeklärte Fragen auf. Insbesondere waren die Frage nach der Energiequelle der Sonne und die Theorie des schwarzen Körpers ungeklärt.

Verborgen in der Struktur der Maxwellgleichungen war auch die Relativitätstheorie, wie sich aus Untersuchungen der Elektrodynamik bewegter Körper von Hendrik Antoon Lorentz und Henri Poincaré andeutete und die Albert Einstein im folgenden Jahrhundert in voller Tragweite erkannte.

Moderne Physik

Das 20. Jahrhundert begann mit der Entdeckung der beiden grundlegenden Säulen der modernen Physik, der Quantentheorie durch Max Planck (1900) und der Relativitätstheorie durch Albert Einstein. Beide Theorien führten zu einer grundlegenden Umgestaltung der Physik.

Auf experimenteller Seite war einerseits die Entdeckung der Radioaktivität Ende des 19. Jahrhunderts (Henri Becquerel) und deren Erforschung Anfang des 20. Jahrhunderts durch Marie Curie von ausschlaggebender Bedeutung, gefolgt von der Entdeckung des Atomkerns durch Ernest Rutherford (Rutherford-Streuversuch). Als erstes Elementarteilchen war noch im 19. Jahrhundert das Elektron in Kathodenstrahlen entdeckt worden (J. J. Thomson). Ein wichtiger Fortschritt war auch die Untersuchung bisher nicht bekannter Teile des elektromagnetischen Spektrums mit der Entdeckung der Röntgenstrahlung durch Wilhelm Conrad Röntgen, mit großen Auswirkungen auf die Medizin und die mikroskopische Untersuchung von Festkörpern (Max von Laue, William Henry Bragg, William Lawrence Bragg).

Relativitätstheorie

Die spezielle Relativitätstheorie (SRT) wurde nach Vorarbeiten von Hendrik Antoon Lorentz und Henri Poincaré durch Albert Einstein begründet. Er erkannte als erster ihre volle Tragweite. Durch die postulierte Gleichberechtigung aller Beobachter (Relativitätsprinzip) und durch die Invarianz der Lichtgeschwindigkeit, war es notwendig geworden, Raum und Zeit neu zu definieren. Beide Größen waren nach der SRT nicht mehr absolut, sondern von der Wahl des Bezugssystems abhängig. An die Stelle der Galilei-Transformation trat nun die Lorentz-Transformation.

Die ebenfalls von Einstein begründete allgemeine Relativitätstheorie (ART) dehnte die Erkenntnisse der SRT auf Nicht-Inertialsysteme aus. Demnach sind Gravitationswirkungen und Trägheitskräfte zueinander vollkommen äquivalent. Daraus folgte sowohl die Gleichheit von schwerer und träger Masse als auch die Krümmung der Raumzeit. Die noch in der klassischen Physik stillschweigend als zutreffend angesehene euklidische Geometrie des Raumes erwies sich nun als nicht mehr tragfähig. Die ART fand schon bald nach dem Ersten Weltkrieg Bestätigung in Beobachtungen (Lichtablenkung am Rand der Sonne bei Sonnenfinsternis, Arthur Eddington) und die darin formulierten Kosmologischen Modelle (Friedmann, Georges Lemaître) in der Entdeckung der Expansion des Universums (Edwin Hubble).

Quantentheorie

Die Quantentheorie hat ihre Wurzeln in der Quantenhypothese, mit der es Max Planck gelang, das Spektrum der Wärmestrahlung des Schwarzen Körpers durch das Plancksches Strahlungsgesetz zu erklären: Planck nahm an, dass die Materie Strahlung nicht kontinuierlich, sondern in kleinen „Portionen“ – Quanten – absorbiert und emittiert. Albert Einstein schloss daraus auf den Teilchencharakter des Lichts (Photon) und erklärte damit den Photoeffekt, der schon im 19. Jahrhundert von Wilhelm Hallwachs entdeckt worden war. Der Teilchencharakter des Lichts stand in krassem Widerspruch zu der Wellentheorie des Lichts, die sich bisher ausgezeichnet bewährt hatte. Louis de Broglie ging später sogar noch einen Schritt weiter und postulierte, dass dieser Welle-Teilchen-Dualismus nicht nur eine Eigenschaft des Lichts sei, sondern ein Grundprinzip der Natur. Daher schrieb er auch der Materie einen Wellencharakter zu. Niels Bohr, Arnold Sommerfeld und andere entwickelten das halbklassische Bohrsche Atommodell mit quantisierten Energien, das eine erste plausible Erklärung für die Linienspektren der Atome gab. Die ältere Quantentheorie erwies sich bald insbesondere in der Erklärung komplexer Spektren als ungenügend. Um 1925 wurde durch Werner Heisenberg, Max Born (von dem die statistische Interpretation der Wellenfunktion stammt), Pascual Jordan und Wolfgang Pauli die Matrizenmechanik entwickelt. Hier wurden die Quantisierungserscheinungen durch die Nichtvertauschbarkeit der den grundlegenden Messgrößen wie Impuls und Ort zugeordneten Operatoren erklärt. Außerdem erkannte Heisenberg dass diese Größen nicht gleichzeitig exakt bestimmt sind und schätzte dies in seiner Unschärferelation ab. Erwin Schrödinger formulierte unabhängig davon mit der Schrödingergleichung die Grundlage der Wellenmechanik. Diese Gleichung ist eine Eigenwert-Gleichung: Die Eigenwerte des Hamilton-Operators sind die Energien der möglichen Zustände. Die Matrizen- und die Wellenmechanik erwiesen sich als zwei Aspekte derselben Theorie: Der eigentlichen Quantenmechanik. Bis Ende der 1920er Jahre war die Formulierung insbesondere durch Paul Dirac zu einem Abschluss gebracht worden und die neue Theorie erzielte große Erfolge durch Anwendung nicht nur in der Atomphysik, sondern auch bei Molekülen, Festkörpern und auf anderen Gebieten. Der Spin, eine fundamentale Eigenschaft aller Teilchen, die sich in der klassischen Physik nicht verstehen lässt, wurde entdeckt. Der grundlegende Unterschied von Bosonen (ganzzahliger Spin, Bose-Einstein-Statistik) einerseits und Fermionen (halbzahliger Spin, Fermi-Dirac-Statistik) andererseits wurde erkannt (siehe Spin-Statistik-Theorem von Wolfgang Pauli). Mit der Klein-Gordon-Gleichung und der Diracgleichung gelangen relativistische Formulierungen der Quantentheorie. Die daraus entwickelte Vorhersage von Antiteilchen konnte durch Carl D. Anderson bestätigt werden.

Die Grundlagen der Quantentheorie wurden in Schlüsselexperimenten wie im Franck-Hertz-Versuch (quantisierter inelastischer Stoß von Elektronen mit Atomen), im Millikan-Versuch (Quantisierung der Ladung), im Compton-Effekt (Streuung von Photonen an freien Ladungsträgern), im Stern-Gerlach-Versuch (Richtungsquantelung des Drehimpulses) und im Davisson-Germer-Experiment (Beugung von Materiewellen) bestätigt.

Noch mehr als die spezielle und die allgemeine Relativitätstheorie stellte die Quantenphysik einen Paradigmenwechsel in der Physik dar. Die Klassische Physik war ihrem Prinzip nach[18] streng deterministisch. Das bedeutet, dass gleiche Anfangsbedingungen unter identischen Umständen immer zu den gleichen Versuchsergebnissen führen. Dieser Determinismus war in der Quantenphysik nicht gegeben. Max Born führte die statistische Interpretation der Wellenfunktionen ein, ausgebaut in der Kopenhagener Deutung der Quantentheorie durch Bohr und Heisenberg 1928. Einstein lehnte diese Deutung vehement ab, blieb damit aber isoliert.

1930er Jahre, Anwendungen der Quantentheorie

Die 1930er Jahre waren geprägt vom Ausbau der Kernphysik, die mit der Entwicklung der ersten Teilchenbeschleuniger (insbesondere das Zyklotron durch Ernest O. Lawrence) einen Aufschwung erhielt. Als weiterer grundlegender Elementarteilchen-Baustein neben dem Elektron und Proton kam das Neutron hinzu (James Chadwick) und bald darauf weitere Elementarteilchen, die zunächst vor allem durch natürliche Beschleuniger in Form der Kosmischen Höhenstrahlung untersucht wurden, wobei die wesentlichen neuen Entdeckungen erst nach dem Zweiten Weltkrieg ab der zweiten Hälfte der 1940er Jahre erzielt wurden (P. M. S. Blackett u. a.). Das Neutron war grundlegend für das Verständnis der Kerne und sein Zerfall führte zur Entdeckung der vierten fundamentalen Wechselwirkung (neben Gravitation, elektromagnetischer und der die Kerne zusammenhaltenden starken Wechselwirkung), der schwachen Wechselwirkung. Es wurden erste Kernmodelle entwickelt, so z. B. das Tröpfchenmodell von Carl Friedrich von Weizsäcker. Bis heute gibt es jedoch keine in sich geschlossene befriedigende Theorie des Atomkerns. Ende der 1930er Jahre wurde die Kernspaltung durch Otto Hahn entdeckt und durch Lise Meitner theoretisch gedeutet. Nachdem der Zweite Weltkrieg ausgebrochen war, starteten die USA das Manhattan-Projekt zur Entwicklung von Atombomben. An dem Projekt, das unter der wissenschaftlichen Leitung von J. Robert Oppenheimer stand, waren zahlreiche namhafte Physiker beteiligt. Die erste kontrollierte Kettenreaktion gelang Enrico Fermi 1942 und bildete die Grundlage für die friedliche Nutzung der Kernenergie. Außerdem war dies zusammen mit der Radarforschung im Zweiten Weltkrieg der Beginn von Big Science und massiver Förderung der Naturwissenschaften und Technologie durch staatliche Stellen in den USA und anderen Ländern und durch die Ausbildung eines militärisch-industriellen Komplexes.

Nach der Machtergreifung durch die Nationalsozialisten 1933 verlor Deutschland seine Vorreiterstellung in der Physik, die es im ersten Drittel des 20. Jahrhunderts innegehabt hatte. Zahlreiche Physiker verließen Deutschland und später Österreich, weil sie wegen ihrer jüdischen Abstammung oder ihrem politischen Engagement verfolgt wurden, darunter so namhafte Wissenschaftler wie Einstein, Schrödinger, Meitner und andere. In der so genannten „Deutschen Physik“ (vertreten durch z. B. Philipp Lenard, Johannes Stark, u. a.) wurden wichtige Erkenntnisse der Modernen Physik aus ideologischen Gründen abgelehnt. Wie nicht anders zu erwarten, stellte sich die „Deutsche Physik“ jedoch als wissenschaftliche Sackgasse heraus. Auch Deutschland unternahm im Zweiten Weltkrieg im Rahmen des Uranprojekts militärisch motivierte Forschungen zur Kernspaltung, jedoch war es bis Kriegsende noch weit vom Bau einer Atombombe entfernt. Die Forschung in Deutschland war auf diesem und anderen militärisch relevanten Gebieten nach dem Krieg bis 1956 untersagt. Sie litt außerdem in Deutschland unter den Kriegszerstörungen und der Vertreibung zahlreicher Wissenschaftler unter den Nationalsozialisten und musste nach dem Krieg wieder mühsam Fuß fassen.

In den 1930er Jahren wurde auch die Quantentheorie von Feldern entwickelt (Dirac, Jordan u. a.), mit dem grundlegenden Bild von Wechselwirkungen vermittelt durch den Austausch von Teilchen (Hideki Yukawa, Fermi).

Aufschwung der Physik nach dem Zweiten Weltkrieg

Die führende Rolle in der Physik übernahmen nach dem Zweiten Weltkrieg die USA. Ende der 1940er Jahre entstanden durch Richard Feynman (der auch nach einer Idee von Dirac die Pfadintegral-Formulierung der Quantenmechanik begründete), Julian Schwinger, Freeman Dyson und andere konsistente Formulierungen von Quantentheorien von Feldern (Quantenfeldtheorie, Quantenelektrodynamik). Aus den Radarforschungen im Zweiten Weltkrieg kamen viele neue experimentelle Verfahren, insbesondere die Entwicklung des Masers (Mitte der 1950er Jahre) und daraus die des Lasers (um 1960), die nicht nur die Spektroskopie revolutionierten, und Methoden wie Kernspinresonanzspektroskopie. Die Festkörperphysik lieferte eine weitere Säule der technologischen Entwicklung in Form von Halbleitern und dem Transistor (John Bardeen, William B. Shockley). Auch lange unverstandene makroskopische Quantenphänomene wie die von Supraleiter (John Bardeen u. a.) und Supraflüssigkeit fanden mit hier auf die Vielteilchenphysik angewandten quantenfeldtheoretischen Methoden eine Erklärung. Die Festkörperphysik sorgte immer wieder für überraschende Entdeckungen (wie Hochtemperatursupraleiter und Quanten-Hall-Effekt in den 1980er Jahren), nicht nur mit großen technologischen Auswirkungen, sondern auch mit theoretischen Ansätzen, die auch die Elementarteilchenphysik und andere Gebiete der Physik befruchteten. Von besonderer Bedeutung war hier die Entwicklung der Theorie der Phasenübergänge und kritischen Phänomene (Lew Landau, Kenneth Wilson). Wilson arbeitete das einflussreiche Konzept der Renormierungsgruppe heraus, die zum Beispiel bei der Theorie von Phasenübergängen und in der Elementarteilchenphysik und Quantenfeldtheorie Anwendung findet.

Entwicklung des Standardmodells

Die Entwicklung der Teilchenbeschleuniger nach dem Krieg führte zur Entdeckung eines ganzen Elementarteilchen-Zoos, in den die Theoretiker besonders ab den 1960er Jahren Ordnung brachten. Dabei erwiesen sich Symmetrien und deren quantenfeldtheoretische Formulierung als Eichtheorien von besonderer Bedeutung. Eichtheorien wurden ursprünglich von Hermann Weyl als Erweiterungen der Allgemeinen Relativitätstheorie eingeführt und erwiesen sich insbesondere in Form von Yang-Mills-Theorien als grundlegend für das sich nun herausbildende Standardmodell der Elementarteilchen und fundamentalen Wechselwirkungen. Von großer Bedeutung war die Entdeckung der Verletzung einer grundlegenden Symmetrie in der schwachen Wechselwirkung, der Paritätsverletzung (1956, postuliert von Yang, Lee und bestätigt im Wu-Experiment). Wesentliche Beiträge leistete Murray Gell-Mann bei der starken Wechselwirkung, speziell durch die Einführung punktförmiger Konstituenten (Quarks), aus denen Mesonen und Baryonen aufgebaut sind und die Ende der 1960er Jahre in Hochenergieexperimenten beobachtet wurden. Ab den 1970er Jahren schälte sich eine spezielle Yang-Mills-Theorie, die Quantenchromodynamik als Theorie der starken Wechselwirkung und ein Baustein des Standardmodells heraus, gefolgt von einer Vereinigung der elektrischen und schwachen Wechselwirkung (Steven Weinberg, Abdus Salam, Sheldon Glashow, 1960er Jahre). Die Entwicklung der großen Beschleuniger, die exemplarisch für Big Science stehen, bei denen tausende Wissenschaftler an den Experimenten nichts Ungewöhnliches sind, bestätigte Stück für Stück dieses Modell bis hin zur Entdeckung des letzten Quarks (Top Quark) in den 1990er Jahren und des Higgs-Teilchens Anfang der 2010er Jahre.

Die theoretische Elementarteilchenphysik wurde in den Jahren nach Abschluss des Standardmodells (Ende der 1970er Jahre) von der Stringtheorie beherrscht, die die Phänomenologie des Standardmodells durch die Betrachtung ausgedehnter (fadenförmiger) statt punktförmiger Elementarteilchen zu erklären versucht und die Lösung eines weiteren großen ungelösten Problems der Physik, der Vereinigung von Gravitation und Quantentheorie, zum Ziel hat. Allerdings leidet die Theorie an dem großen Abstand der Planck-Skala der Beschreibung der Theorie und experimentell zugänglichen Dimensionen. Die Theorie war dagegen sehr fruchtbar für einen neuen gegenseitigen Austausch von Mathematik und Physik.

Weitere Entwicklungen

Die durch die Miniaturisierung elektronischer Schaltungen möglich gemachte Entwicklung des Computers und der Elektronik machte nicht nur die Entwicklung der Teilchenbeschleunigerexperimente, die das Standardmodell bestätigten, möglich, sondern revolutionierte auch die Theoretische Physik. Zu den vor allem durch die Computerentwicklung ermöglichten neuen Zweigen gehört auch die Chaostheorie, die in den 1970er Jahren zu einem Paradigmenwechsel auch in Gebieten wie der klassischen Mechanik führte, die bis dahin als weitgehend abgeschlossen galten. Mit dem Computer erschlossen sich ganz neue Fragestellungen und Verbesserungen der Vorhersagemöglichkeiten von vielen Modellen. Die Miniaturisierung von Schaltkreisen wurde später bis in den Quantenbereich fortgetrieben und es entstanden neue Forschungsfelder wie Mesoskopische Physik und Quanteninformationstheorie.

Im großen Maßstab der Kosmologie und Astrophysik (Quasare und aktive Galaxien, Neutronensterne und Pulsare, Schwarze Löcher) wurden in der zweiten Hälfte des 20. Jahrhunderts ebenfalls sowohl theoretisch als auch auf dem Gebiet der Beobachtungen (Astronomie in den unterschiedlichsten Wellenlängen) große Fortschritte erzielt. Schwarze Löcher wandelten sich von einer exotischen Möglichkeit zu einem etablierten Erklärungsmodell und die Kosmologie wurde insbesondere mit der Entdeckung der 3-K-Hintergrundstrahlung zu einer quantitativen Wissenschaft. Es stellten sich auch vielfältige Verbindungen von der Physik im ganz Kleinen (Elementarteilchen) zur Astrophysik und Kosmologie heraus (Astroteilchenphysik), zum Beispiel bei der Erklärung des Problems solarer Neutrinos. Das Inflationäre Modell wurde zu einem der Bausteine der modernen Naturerklärung, wobei sich Ende des 20. Jahrhunderts in Form der Entdeckung Dunkler Materie und der beschleunigten Expansion des Universums neue grundlegende ungelöste Probleme ergaben.

Siehe auch

- Zeittafel physikalischer Entdeckungen

- Geschichte der Naturwissenschaften

- Liste bedeutender Physiker

- Liste der Nobelpreisträger für Physik

Literatur

Bibliographien

- Roderick W. Home: The history of classical physics. A selected, annotated bibliography. Garland, New York 1984, ISBN 0-8240-9067-5.

- Stephen G. Brush, Lanfranco Belloni: The history of modern physics. An international bibliography. Garland, New York 1983, ISBN 0-8240-9117-5.

Überblicksdarstellungen und Handbücher

- Armin Hermann: Weltreich der Physik. 2. Auflage. GNT Verlag, 1991.

- John Heilbron (Hrsg.): The Oxford Guide to the History of Physics and Astronomy. Oxford University Press, 2005.

- Gerald Holton, Stephen G. Brush: Physics, the Human Adventure. From Copernicus to Newton and Beyond. Rutgers University Press, 2001, ISBN 0-8135-2908-5.

- Friedrich Hund: Geschichte der physikalischen Begriffe. 2. Auflage. Bibliographisches Institut, Mannheim 1978.

- Band 1: Die Entstehung des mechanischen Naturbildes. ISBN 3-411-05543-X.

- Band 2: Die Wege zum heutigen Naturbild. ISBN 3-411-05544-8.

- Friedrich Hund: Grundbegriffe der Physik. Bibliographisches Institut, Mannheim 1969, DNB 457041064. (2. Auflage. 1979, DNB 550539808)

- Robert Locqueneux: Kurze Geschichte der Physik. Vandenhoeck & Ruprecht, Göttingen 1989, ISBN 3-525-03414-8.

- Klaus Mainzer: Physik. In: HWPh. 7, S. 937–947.

- Wolfgang Schreier (Hrsg.): Geschichte der Physik. Diepholz, Berlin 2002, ISBN 3-928186-62-0.

- Emilio Segrè Die großen Physiker und ihre Entdeckungen. 2 Bände, Piper Verlag, München 1986, ISBN 3-492-02935-3.

- Károly Simonyi: Kulturgeschichte der Physik. Harri Deutsch, Thun, Frankfurt am Main 1995, ISBN 3-8171-1379-X.Populäre, bebilderte Darstellung

- Roger G. Newton: From Clockwork to Crapshoot: A History of Physics. Belknap, Cambridge 2007, ISBN 978-0-674-02337-6.

- Albert Einstein, Leopold Infeld: Die Evolution der Physik. Rowohlt, 1995, ISBN 3-499-18342-0.

- Max von Laue: Geschichte der Physik. Ullstein Bücher, 1959,

Lexika

- Charles Coulston Gillispie (Hrsg.): Dictionary of Scientific Biography. 16 Bde., New York 1970–1980.

- Armin Hermann (Hrsg.): Lexikon Geschichte der Physik A-Z. 3. Auflage. Köln 1987, ISBN 3-7614-1010-7.

- J. C. Poggendorff: Biographisch-literarisches Handwörterbuch der exakten Naturwissenschaften. Datenbank, hg. Sächsische Akademie der Wissenschaften zu Leipzig. Verlag Wiley-VCH, Weinheim 2000.

Spezielle Themen

- Mechanik

- René Dugas: A history of mechanics. Routledge and Kegan, 1955

- Istvan Szabo: Geschichte der mechanischen Prinzipien. Birkhäuser, 1987

- Eduard Jan Dijksterhuis Die Mechanisierung des Weltbildes. Springer, Berlin/ Heidelberg/ New York 1956. (Reprint 1983)

- Ernst Mach: Die Mechanik in ihrer Entwickelung. Brockhaus, 1897.

- Verschiedene Bücher von Max Jammer wie The concept of force

- Thermodynamik, Kinetische Gastheorie

- Stephen G. Brush: The Kind of Motion We Call Heat – A History of the Kinetic Theory of Gases in the 19th Century. 2 Bände. North Holland 1976.

- Elektrodynamik

- Edmund T. Whittaker: History of the theories of ether and electricity. 2 Bände, Dover 1989. (zuerst 1910)

- Olivier Darrigol: Electrodynamics from Ampère to Einstein. Oxford University Press, 2003

- John Heilbron: Electricity in the 17th and 18th Century: Study of Early Modern Physics. University of California Press, 1979. (Dover 1999)

- Quantentheorie

- Friedrich Hund: Geschichte der Quantentheorie. 2. Auflage. Bibliographisches Institut, Mannheim 1975, ISBN 3-411-01476-8.

- Jagdish Mehra, Helmut Rechenberg: The historical development of Quantum Theory. 6 Bände, Springer Verlag, New York 1982–2002.

- Bartel Leendert van der Waerden (Hrsg.): Sources of Quantum Mechanics. North Holland 1967. (Dover/ Amsterdam 1968)

- Quantenfeldtheorie, Elementarteilchenphysik

- Abraham Pais: Inward Bound. Of Matter and Forces in the Physical World. Clarendon Press, Oxford, 1986.

- Silvan S. Schweber: QED and the Men Who Made It: Dyson, Feynman, Schwinger, and Tomonaga. Princeton University Press, Princeton 1994.

- Mittelalter

- A. C. Crombie: Augustine to Galileo: The History of Science A.D. 400 - 1650. Penguin 1969, ISBN 0-14-055074-7.

- S. Donati, Andreas Speer: Physik und Naturphilosophie. In: Lexikon des Mittelalters. Band 6, J. B. Metzler, 2000, S. 2111–2117.

- Edward Grant: Physical Science in the Middle Ages. Wiley History of Science Series, John Wiley, New York/ London 1971.

- Edward Grant: The Foundations of Modern Science in the Middle Ages. Their Religious, Institutional and Intellectual Contexts. Cambridge University Press, Cambridge 1996, ISBN 0-521-56762-9.

- Edward Grant (Hrsg.): A Sourcebook in Medieval Science. Harvard University Press, Cambridge 1974, ISBN 0-674-82360-5.

- Toby E. Huff: The Rise of Early Modern Science. Islam, China, and the West. Cambridge University Press, 2003, ISBN 0-521-52994-8.

- David C. Lindberg: The Beginnings of Western Science. University of Chicago Press, Chicago 1992, ISBN 0-226-48230-8.

- David C. Lindberg (Hrsg.): Science in the Middle Ages. University of Chicago Press, Chicago 1976, ISBN 0-226-48233-2.

- M. H. Shank (Hrsg.): The Scientific Enterprise in Antiquity and the Middle Ages. University of Chicago Press, 2000, ISBN 0-226-74951-7.

- J. Thijssen: Die Stellung der scholastischen Naturphilosophie in der Geschichte der Physik. Herbst des Mittelalters oder Frühling der Neuzeit? In: Jan A. Aertsen, Martin Pickavé (Hrsg.): Herbst des Mittelalters? Fragen zur Bewertung des 14. und 15. Jahrhunderts. De Gruyter, 2004, S. 512ff.

- Ältere Darstellungen

Ernst Gerland, Edmund Hoppe, Johann Christian Poggendorff, August Heller, Ferdinand Rosenberger, Emil Wilde (Optik), Carl Ramsauer (Experimente)

Einzelnachweise

- ↑ 1,0 1,1 Schreier 1990, 451

- ↑ Eugene Hecht: Optik. 4. Auflage. Oldenbourg, München/ Wien 2005, ISBN 3-486-27359-0, S. 1.

- ↑ Károly Simonyi: Kulturgeschichte der Physik. Kapitel „Mystik und Mathematik: Pythagoras“. Verlag Harri Deutsch, Thun/Frankfurt am Main 1990, S. 61–66.

- ↑ Vgl. De Genesi ad litteram, De civitate Dei 21, 8; Donati/Speer.

- ↑ Donati/Speer mit Verweis auf Quaest. nat. 6 und 22

- ↑ Donati/Speer

- ↑ Opus maius, Teil 4, nach Donati/Speer

- ↑ Donati/Speer

- ↑ Donati/Speer

- ↑ Enrico Giannetto: The impetus theory: Between history of physics and science education. In: Science & Education. 2/3 (1993), S. 227–238.

- ↑ Hier nach Flasch, Das philosophische Denken im Mittelalter, Stuttgart: Reclam 2000, 543

- ↑ Donati/Speer

- ↑ Vgl. Flasch, 545

- ↑ Vgl. Flasch, 569–572

- ↑ Barry Gower, Speculation in Physics: the history and practice of Naturphilosphie, Stud. Hist. Phil. Sci., 3, 1973, 301

- ↑ Walther Gerlach, in Propyläen Weltgeschichte (19. Jahrhundert), und Walther Gerlach, Zum 150. Geburtstag von Julius Robert Mayer, Physikalische Blätter 1964, S. 407, doi:10.1002/phbl.19640200903 (freier Volltext)

- ↑ Thomas S. Kuhn machte 1959 in einem klassischen Aufsatz die Naturphilosophie als eine der Faktoren aus, die zum Prinzip der Energieerhaltung führten. Thomas S. Kuhn, Energy conservation as an example of simultaneous discovery, in Marshall Clagett u.a., Critical problems in the history of science, University of Wisconsin Press, 1959, S. 321-356, nachgedruckt in Kuhn: The essential tension, University of Chicago Press, 1977, S. 66-104. Zwei weitere Trigger Factors waren nach Kuhn die Beschäftigung mit Maschinen und Konversionsprozessen.

- ↑ Die weite Verbreitung chaotischen Verhaltens auch in der klassischen Physik wurde erst ab den 1970er Jahren in der Chaostheorie deutlich und führte auch hier zu einem Paradigmenwechsel.

Weblinks

- Überblicksdarstellungen

- Bernhard Szallies: Zeittafel

- Johann Carl Fischer: Geschichte der Naturwissenschaften. Göttingen 1801

- Joachim Schummer: Einführung in die Geschichte und Philosophie der Physik. Universität Karlsruhe

- Pierre Duhem: History of Physics. In: The Catholic Encyclopedia. Band 12, Robert Appleton Company, New York 1911. (bei wikisource)

- Paul Halsall: Internet History of Science Sourcebook. 1998–2007

- Zapata Marín, Oswaldo: Il Saggiatore: Passages on the History of Physics. (mdy) 2009, abgerufen am 29. November 2013.

- Geschichte der Physik - Techniklexikon - abgerufen am 19. Dez. 2013

- Mittelalter

- Stephen Carey: Mechanics in the Middle Ages, kommentierte Bibliographie

- Neuzeit

- Gerald Holton / Stephen G. Brush: Bibliographie zu: Physics, the Human Adventure: From Copernicus to Newton and Beyond, Rutgers University Press, 2001

- Spezielle Themen

- L L. Whyte: Essay on Atomism from Democritus to 1960, Wesleyan University Press 1961

- Friedrich Albert Lange: Geschichte des Materialismus, Leipzig 2. A. 1873/75.

- Philosophy of Science Case Studies und History of Philosophy of Science, Aufsätze von PhilSci Archive